Équipe de rédaction de Getronics

Dans cet article :

L'intelligence artificielle (IA) est passée en quelques années d'un concept relativement obscur à quelque chose qui change rapidement nos vies. Selon une étude récente, le marché mondial de l'IA connaîtra une croissance annuelle de 37 % entre 2023 et 2030, créant plus de 130 millions d'emplois. Bien que cette prolifération rapide de l'IA suscite autant d'enthousiasme que de crainte, il y a un sujet qui attire l'attention de tous : la réglementation.

Les réglementations en matière d'IA sont inévitables compte tenu des progrès et de l'intégration des systèmes d'IA dans pratiquement toutes les facettes du monde moderne. Des juridictions clés, telles que l'Union européenne, sont déjà en train d'introduire des cadres législatifs destinés à mettre de l'ordre dans ce qui a été décrit comme la version technologique du Far West, et beaucoup d'autres suivront à mesure que la nécessité d'une surveillance au niveau gouvernemental augmentera.

La loi européenne sur l'IA

L'Acte sur l'IA de l'UE est un texte législatif historique qui vise à créer un cadre juridique complet régissant l'utilisation et le développement de l'IA dans tous les États membres. Composante essentielle de la stratégie numérique plus large de l'UE, l'Acte sur l'IA de l'UE reflète une approche proactive visant à relever les défis éthiques, sociétaux et techniques posés par les technologies de l'IA qui progressent rapidement.

La loi, adoptée par les législateurs européens le 13 mars 2024, vise à favoriser un environnement dans lequel les technologies de l'IA peuvent prospérer, en stimulant l'innovation et la croissance économique tout en veillant à ce que ces développements profitent à tous les citoyens et soient alignés sur l'intérêt public. La loi garantira également que les Européens peuvent faire confiance à ce que l'IA leur offre.

La loi sur l'IA de l'UE

- Traiter les risques spécifiquement créés par les applications de l'IA.

- Interdire les pratiques d'IA qui présentent des risques inacceptables.

- Établir une liste des applications à haut risque.

- Définir des exigences claires pour les systèmes d'IA destinés à des applications à haut risque.

- Définir des obligations spécifiques pour les déployeurs et les fournisseurs d'applications d'IA à haut risque.

- Mettre en place des mesures d'exécution après la mise sur le marché d'un système d'IA donné.

- Mettre en place une structure de gouvernance aux niveaux européen et national.

- Exiger une évaluation de la conformité avant la mise en service d'un système d'IA.

Une approche de la gouvernance de l'IA fondée sur les risques

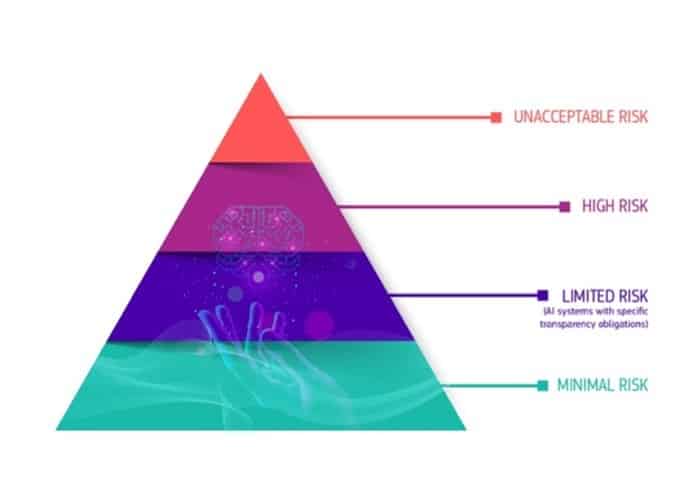

Le cadre réglementaire établi par la loi sur l'IA introduit un principe selon lequel plus le risque posé par un système d'IA est élevé, plus la réglementation à laquelle il est soumis est stricte. Cette approche garantit que les systèmes d'IA susceptibles d'avoir un impact significatif sur la société ou les individus sont soumis à une surveillance et à un contrôle plus rigoureux.

L'un des principaux aspects de la loi sur l'IA consiste à classer certaines applications d'IA dans la catégorie des applications présentant un risque inacceptable, ce qui revient à interdire leur utilisation au sein de l'Union européenne. Cette catégorie comprend les applications d'IA qui :

- Manipuler le comportement humain au point de nuire aux individus. Il s'agit de systèmes conçus pour influencer des actions ou des décisions susceptibles de nuire à leur bien-être ou à leur autonomie.

- Faciliter l'évaluation défavorable des individus en fonction de leur comportement social ou de leurs caractéristiques personnelles. Le système de crédit social mis en place en Chine en est un bon exemple. Il restreint les libertés et les opportunités d'une personne en fonction de son statut social, déterminé par son comportement et d'autres traits personnels.

- Permettre la détection à distance et en temps réel des personnes dans les espaces publics et leur identification biométrique sans leur consentement. Bien que ces pratiques soient largement interdites en raison de leur nature intrusive, la loi prévoit des exceptions pour la prévention du terrorisme ou les enquêtes sur des crimes graves, reconnaissant ainsi l'équilibre entre les préoccupations en matière de protection de la vie privée et les besoins en matière de sécurité.

Les systèmes d'IA identifiés comme étant à haut risque comprendront les systèmes d'IA utilisés dans des domaines clés tels que les infrastructures critiques (par exemple, les transports), la formation éducative ou professionnelle (par exemple, la notation des examens), les composants de sécurité des produits (par exemple, l'IA dans la chirurgie assistée par robot) et l'emploi (par exemple, les logiciels de tri de CV). Les systèmes d'IA à haut risque seront soumis à des obligations strictes avant leur mise sur le marché :

- Des systèmes adéquats d'évaluation et d'atténuation des risques.

- Enregistrement des activités pour assurer la traçabilité des résultats.

- Des informations claires et adéquates à l'intention du responsable du déploiement.

- Des mesures de surveillance humaine appropriées pour minimiser les risques.

- Niveau élevé de robustesse, de sécurité et de précision.

- Une documentation détaillée fournit toutes les informations sur le système et sa finalité pour permettre aux autorités d'évaluer sa conformité.

Par ailleurs, les systèmes d'IA identifiés comme présentant un risque limité seront soumis à des obligations de transparence spécifiques afin de garantir que les humains sont informés lorsque cela est nécessaire. Lors de l'utilisation d'un chatbot, par exemple, les humains doivent être informés qu'ils interagissent avec une machine afin qu'ils puissent décider en connaissance de cause s'ils souhaitent continuer à utiliser le système. Les fournisseurs devront également veiller à ce que le contenu généré par l'IA soit identifiable.

Les systèmes d'IA présentant un risque minimal ne feront l'objet d'aucune restriction et pourront être utilisés librement. Il s'agit notamment d'applications telles que les jeux vidéo ou les filtres anti-spam basés sur l'IA.

Qui sera concerné ?

La loi sur l'IA de l'UE touchera principalement les fournisseurs, qui sont définis de manière large pour inclure toutes les entités juridiques - qu'il s'agisse d'autorités publiques, d'institutions, de sociétés ou d'autres organismes - qui développent des systèmes d'IA ou commandent le développement de systèmes d'IA. Cette définition large garantit que toute organisation impliquée dans la mise sur le marché européen de technologies d'IA ou dans la mise en service de tels systèmes au sein de l'Union relève du champ d'application de la loi. Les responsabilités des fournisseurs en vertu de la loi incluent, mais ne sont pas limitées à :

- Respect des droits de l'homme : Veiller à ce que les systèmes d'IA ne compromettent pas les droits fondamentaux des personnes, notamment la protection de la vie privée, la non-discrimination et la protection des données à caractère personnel.

- Gestion des risques : Procéder à des évaluations approfondies des risques afin d'identifier et d'atténuer tout dommage potentiel que leurs systèmes d'IA pourraient causer aux individus ou à la société.

- Mesures de transparence : Fournir des informations claires et compréhensibles sur le fonctionnement de leurs systèmes d'IA, la logique qui sous-tend les décisions en matière d'IA et les implications de leur utilisation.

- Normes de qualité et de sécurité : Adhérer à des normes de qualité et de sécurité prédéfinies qui garantissent que les systèmes d'IA sont fiables, sûrs et adaptés à l'usage auquel ils sont destinés.

La loi européenne sur l'IA aborde également les responsabilités des utilisateurs de systèmes d'IA, y compris les personnes morales et physiques. Le champ d'application de la loi s'étend ainsi aux particuliers, et non plus seulement aux entreprises ou aux organisations.

En vertu de la loi, les utilisateurs de systèmes d'IA sont tenus de :

- Utilisez les systèmes d'IA de manière responsable : Suivez les instructions et les lignes directrices du fabricant pour utiliser les technologies de l'intelligence artificielle en toute sécurité.

- Surveillance et rapports : Contrôler les performances des systèmes d'IA utilisés et signaler tout dysfonctionnement ou risque aux autorités ou fournisseurs compétents.

- Gouvernance des données : Veillez à ce que toutes les données utilisées en lien avec les systèmes d'IA soient traitées conformément aux lois strictes de l'UE en matière de protection des données, telles que le GDPR, afin de protéger la vie privée et les informations personnelles des individus.

Que réglementera la loi européenne sur l'IA ?

La loi sur l'IA est un texte législatif historique qui abordera plusieurs domaines clés liés au déploiement et au fonctionnement des systèmes d'IA.

Éthique et responsabilité

Les systèmes d'IA ont le potentiel d'avoir un impact sur la société, à la fois positif et négatif. Les considérations éthiques sont primordiales, car les décisions prises par les systèmes d'IA peuvent affecter la vie, les moyens de subsistance et les droits des personnes.

La loi sur l'IA vise à garantir que l'IA est développée et utilisée de manière éthique, qu'elle respecte les droits de l'homme et qu'elle préserve la sécurité des personnes. Elle souligne la nécessité de concevoir les systèmes d'IA selon une approche centrée sur l'homme, en donnant la priorité au bien-être humain et aux normes éthiques.

Transparence et responsabilité

L'un des défis posés par les systèmes d'IA, en particulier ceux basés sur l'apprentissage automatique et l'apprentissage profond, est leur nature de "boîte noire". Cette opacité peut rendre difficile la compréhension de la manière dont les décisions sont prises, ce qui suscite des inquiétudes en matière d'équité, de partialité et de discrimination.

La loi sur l'IA impose une plus grande transparence et une meilleure documentation des systèmes d'IA, en exigeant des explications sur leur fonctionnement, la logique qui sous-tend leurs décisions et les données qu'ils utilisent. Cela est essentiel pour renforcer la responsabilité et garantir que les systèmes d'IA ne perpétuent pas ou n'exacerbent pas les inégalités sociétales.

Compétitivité

Dans la course mondiale au progrès technologique, l'UE entend se positionner en tant que chef de file de l'innovation éthique en matière d'IA. En établissant des règles claires et harmonisées pour l'IA, la loi sur l'IA vise à créer un environnement stable et prévisible qui encourage l'investissement et la recherche dans les technologies de l'IA.

Cette clarification réglementaire vise à renforcer la compétitivité des entreprises européennes sur la scène internationale, en leur permettant d'innover tout en respectant des normes éthiques et de sécurité élevées.

Confiance de l'utilisateur final

L'acceptation et la confiance du public dans les technologies de l'IA sont essentielles à leur adoption à grande échelle et à leur succès. La loi sur l'IA vise à renforcer la confiance du public dans les systèmes d'IA en mettant en œuvre des garanties solides, des normes éthiques et des exigences de transparence.

En veillant à ce que les technologies de l'IA soient utilisées de manière à protéger la société et à lui être bénéfiques, on s'attend à ce que la confiance des citoyens augmente, ce qui est essentiel pour intégrer l'IA dans divers aspects de la vie quotidienne et de l'économie.

Réglementation de l'IA dans d'autres juridictions

L'UE n'est pas la seule à s'efforcer de réglementer l'IA : les États-Unis et le Royaume-Uni ont fait des progrès significatifs dans l'introduction de politiques nationales.

En Californie, où se trouvent des leaders de l'IA comme OpenAI, Microsoft et Google, un projet de loi a récemment été présenté afin d'établir "des normes de sécurité claires, prévisibles et de bon sens pour les développeurs des systèmes d'IA les plus grands et les plus puissants", en adoptant une approche qui se concentre étroitement sur les entreprises qui construisent les modèles à grande échelle et sur la possibilité qu'ils puissent causer des dommages à grande échelle s'ils ne sont pas contrôlés.

Par ailleurs, la loi locale 144 de la ville de New York, qui a été introduite en 2021 et s'applique aux employeurs utilisant des AEDT pour évaluer les candidats, exige qu'un audit sur les préjugés soit effectué sur les processus d'embauche automatisés.

Des mesures sont également prises au niveau fédéral. En octobre, le président Biden a publié un décret visant à établir de nouvelles normes de sûreté et de sécurité en matière d'IA. Ce décret prévoit les actions suivantes :

- Les développeurs des systèmes d'intelligence artificielle les plus puissants doivent communiquer au gouvernement américain les résultats des tests de sécurité et d'autres informations essentielles.

- Élaborer des normes, des outils et des tests pour garantir que les systèmes d'IA sont sûrs, sécurisés et dignes de confiance.

- Protéger contre les risques liés à l'utilisation de l'IA pour créer des matériaux biologiques dangereux.

- Protéger les Américains contre la fraude et la tromperie par l'IA en établissant des normes et des bonnes pratiques pour détecter les contenus générés par l'IA et authentifier les contenus officiels.

- Mettre en place un programme de cybersécurité avancée afin de développer des outils d'IA permettant de trouver et de corriger les vulnérabilités des logiciels critiques.

- Ordonner l'élaboration d'un mémorandum sur la sécurité nationale qui oriente les actions futures en matière d'IA et de sécurité.

Pendant ce temps, les législateurs britanniques planifient également leurs propres règles. Le gouvernement britannique a publié son livre blanc sur l'IA en mars 2023, qui présente ses propositions pour réglementer l'utilisation de l'IA au Royaume-Uni. Le livre blanc s'inscrit dans le prolongement du document d'orientation sur la réglementation de l'IA, qui présentait la vision du gouvernement britannique pour l'avenir d'un régime réglementaire de l'IA "pro-innovation" et "spécifique au contexte" au Royaume-Uni.

Le livre blanc propose une approche de la réglementation de l'IA différente de celle de la loi européenne sur l'IA. Au lieu d'introduire de nouvelles règles générales pour réglementer l'IA au Royaume-Uni, le gouvernement britannique cherche à définir les attentes en matière de développement de l'IA en collaboration avec les régulateurs existants, tels que la Financial Conduct Authority, et à leur donner les moyens de réglementer l'utilisation de l'IA dans le cadre de leurs attributions respectives.

Interactions entre la loi sur l'IA et le GDPR de l'UE

Lorsque la loi européenne sur l'IA entrera en vigueur, elle comptera parmi les premières et les plus importantes réglementations au monde sur l'IA. Cela a naturellement amené les gens à réfléchir à ses implications pour le règlement général sur la protection des données (RGPD), qui est entré en vigueur en 2018.

La loi sur l'IA et le GDPR diffèrent par leur champ d'application. La loi sur l'IA s'applique aux fournisseurs, aux utilisateurs et aux participants de la chaîne de valeur de l'IA, tandis que le GDPR s'applique plus étroitement à ceux qui traitent des données à caractère personnel ou offrent des biens ou des services, y compris des services numériques, aux personnes concernées dans l'UE. Les systèmes d'IA qui ne traitent pas de données à caractère personnel ne relèvent donc pas du GDPR.

Il existe toutefois des réserves à ce sujet. L'une des lacunes potentielles entre la loi sur l'IA et le GDPR est l'obligation pour les fournisseurs de systèmes d'IA de faciliter la surveillance humaine. Toutefois, il n'a pas encore été défini quelles mesures doivent être prises pour permettre cette supervision et dans quelle mesure la supervision humaine sera requise pour des systèmes d'IA spécifiques. L'implication potentielle est que les systèmes d'IA ne seront pas considérés comme partiellement automatisés ; par conséquent, les obligations de l'article 22 peuvent s'appliquer.

La loi sur l'IA indique également que les fournisseurs de systèmes d'IA à haut risque pourraient avoir besoin de traiter des catégories particulières de données à caractère personnel pour la surveillance et la détection des préjugés. Il est intéressant de noter que la loi sur l'IA ne fournit pas explicitement de base légale pour ce faire, et que les dispositions du GDPR constituent une zone grise lorsqu'elles sont appliquées dans ce contexte.

Il pourrait y avoir un motif de traitement licite pour éviter les données biaisées et la discrimination en vertu de la disposition relative à l'intérêt légitime de l'article 6, paragraphe 1, point f), mais lors du traitement de catégories particulières de données, une exemption prévue à l'article 9, paragraphe 2, doit également être respectée. Cela signifie qu'il faut plus qu'un intérêt légitime. En théorie, les opérateurs de systèmes pourraient obtenir le consentement explicite des personnes concernées pour traiter les données afin d'éliminer les biais, mais cela n'est tout simplement pas faisable.

Il s'agit là de deux exemples de points d'achoppement potentiels entre la loi européenne sur l'IA et le GDPR. Les deux cadres juridiques sont des entreprises complexes dont les champs d'application, les définitions et les exigences sont différents, ce qui créera des défis en matière de conformité et de cohérence, qui doivent être relevés.

Quand la loi sur l'IA entre-t-elle en vigueur ?

La loi sur l'IA devait initialement entrer en vigueur en 2022, mais, comme c'est toujours le cas pour les grands projets législatifs de ce type, il y a eu des contretemps.

L'UE a officiellement approuvé la loi sur l'IA le13 mars 2024, lorsque les députés du Parlement européen ont voté en faveur de son adoption, avec une majorité de 523 voix pour et 461 voix contre. Le Conseil européen devrait maintenant approuver officiellement le texte final de la loi sur l'IA en avril 2024. Après cette dernière étape formelle et la conclusion des travaux linguistiques sur la loi sur l'IA, la loi sera publiée au Journal officiel de l'UE et entrera en vigueur 20 jours après sa publication.

Une fois la loi sur l'IA entrée en vigueur, les organisations auront entre six et 36 mois pour se conformer à ses dispositions, en fonction du type de système d'IA qu'elles développent ou déploient :

- 6 mois pour les systèmes d'IA interdits ;

- 12 mois pour les obligations spécifiques concernant les systèmes d'IA à usage général ;

- 24 mois pour la plupart des autres engagements, y compris les systèmes à haut risque de l'annexe III ; et

- 36 mois pour les obligations liées aux systèmes à haut risque de l'annexe II.

Alors que ce texte historique est en passe de devenir une loi, les entreprises doivent comprendre ses implications et se préparer aux changements qu'elle apportera. Cette préparation implique plusieurs actions clés pour garantir la conformité et tirer parti des possibilités offertes par un environnement d'IA bien réglementé.

Tout d'abord, les entreprises doivent procéder à un examen approfondi de leurs systèmes et applications d'IA existants. Cet audit doit permettre d'identifier les domaines dans lesquels leur technologie pourrait ne pas être conforme aux réglementations à venir. Étant donné que la loi sur l'IA met l'accent sur les niveaux de risque, il est essentiel de comprendre où se situe chaque système en ce qui concerne son impact potentiel sur les droits et la sécurité des personnes. Les entreprises pourraient être amenées à modifier ou à supprimer certaines fonctionnalités de l'IA qui entrent dans les catégories de risque les plus élevées ou qui sont jugées inacceptables en vertu de la loi.

Les entreprises doivent également se concentrer sur la mise en œuvre de processus internes solides qui garantissent la transparence et la responsabilité lors de l'utilisation de l'IA. Cela implique d'établir des pratiques de documentation transparentes, de veiller à ce que les processus de prise de décision en matière d'IA soient explicables et de mettre en place des mécanismes de suivi et d'établissement de rapports sur les performances et l'impact de l'IA.