Equipo editorial de Getronics

En este artículo:

La inteligencia artificial (IA) ha pasado de ser un concepto relativamente oscuro a algo que está cambiando rápidamente nuestras vidas en tan solo unos pocos años. Según un estudio reciente, el mercado mundial de la IA crecerá un 37% anual entre 2023 y 2030, creando más de 130 millones de puestos de trabajo. Aunque esta rápida proliferación de la IA suscita entusiasmo y temor a partes iguales, dependiendo de a quién se pregunte, hay un elefante en la habitación: la regulación.

Las normativas sobre IA son inevitables con el avance y la integración de los sistemas de IA en prácticamente todas las facetas del mundo moderno. Jurisdicciones clave como la Unión Europea ya están avanzando en la introducción de marcos legislativos diseñados para poner el orden necesario en lo que se ha citado como la versión tecnológica del Salvaje Oeste, y muchas más seguirán a medida que aumente la necesidad de supervisión a nivel gubernamental.

La Ley de IA de la UE

La Ley de Inteligencia Artificial de la UE es un acto legislativo histórico cuyo objetivo es crear un marco jurídico completo que regule el uso y desarrollo de la inteligencia artificial en todos los Estados miembros. Componente vital de la estrategia digital más amplia de la UE, la Ley de la IA de la UE refleja un enfoque proactivo para abordar los retos éticos, sociales y técnicos que plantean las tecnologías de IA en rápido avance.

La Ley, aprobada por los legisladores europeos el 13 de marzo de 2024, tiene como objetivo fomentar un entorno en el que las tecnologías de IA puedan prosperar, impulsando la innovación y el crecimiento económico y garantizando al mismo tiempo que estos avances beneficien a todos los ciudadanos y estén en consonancia con el interés público. La Ley también garantizará que los europeos puedan confiar en lo que ofrece la IA.

La Ley de Inteligencia Artificial de la UE:

- Abordar los riesgos creados específicamente por las aplicaciones de IA.

- Prohibir las prácticas de IA que planteen riesgos inaceptables.

- Determine una lista de aplicaciones de alto riesgo.

- Establecer requisitos claros para los sistemas de IA para aplicaciones de alto riesgo.

- Definir obligaciones específicas para los implantadores y proveedores de aplicaciones de IA de alto riesgo.

- Implantar medidas coercitivas tras la comercialización de un determinado sistema de IA.

- Establecer una estructura de gobierno a escala europea y nacional.

- Exigir una evaluación de conformidad antes de poner en servicio un sistema de IA.

Un enfoque de la gobierno de la IA basado en los riesgos

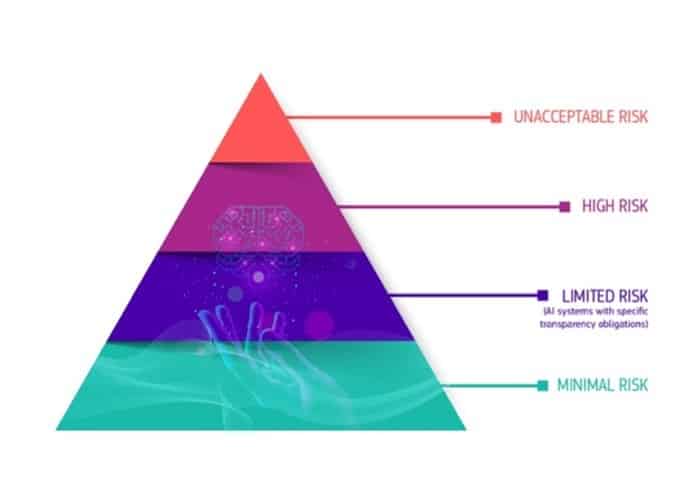

El marco regulador establecido por la Ley de IA introduce el principio de que cuanto mayor es el riesgo que plantea un sistema de IA, más estricta es la normativa a la que se enfrenta. Este planteamiento garantiza que los sistemas de IA con potencial para afectar significativamente a la sociedad o a las personas estén sujetos a una supervisión y un control más rigurosos.

Uno de los aspectos clave de la Ley de IA es la categorización de determinadas aplicaciones de IA como de riesgo inaceptable, lo que prohíbe su uso en la Unión Europea. Esta categoría incluye las aplicaciones de IA que:

- Manipulan el comportamiento humano hasta el punto de que pueden causar daño a las personas. Se trata de sistemas diseñados para influir en acciones o decisiones que podrían perjudicar su bienestar o autonomía.

- Facilitar la evaluación desfavorable de los individuos en función de su comportamiento social o sus características personales. Un ejemplo destacado es el sistema de crédito social implantado en China, que restringe las libertades y oportunidades de una persona en función de su estatus social, determinado por su comportamiento y otros rasgos personales.

- Permitir la detección a distancia en tiempo real de personas en espacios públicos y su identificación biométrica sin su consentimiento. Aunque estas prácticas están ampliamente prohibidas por su carácter intrusivo, la Ley especifica excepciones para prevenir el terrorismo o investigar delitos graves, reconociendo el equilibrio entre las preocupaciones por la privacidad y las necesidades de seguridad.

Los sistemas de IA identificados como de alto riesgo incluirán sistemas de IA utilizados en áreas clave como infraestructuras críticas (por ejemplo, transporte), formación educativa o profesional (por ejemplo, calificación de exámenes), componentes de seguridad de productos (por ejemplo, IA en cirugía asistida por robots) y empleo (por ejemplo, software de clasificación de CV). Los sistemas de IA de alto riesgo estarán sujetos a estrictas obligaciones antes de poder comercializarse:

- Sistemas adecuados de evaluación y mitigación de riesgos.

- Registro de la actividad para garantizar la trazabilidad de los resultados.

- Información clara y adecuada al desarrollador.

- Medidas adecuadas de supervisión humana para minimizar el riesgo.

- Alto nivel de solidez, seguridad y precisión.

- La documentación detallada proporciona toda la información sobre el sistema y su finalidad para que las autoridades evalúen su conformidad.

Mientras tanto, los sistemas de IA identificados como de riesgo limitado estarán sujetos a obligaciones específicas de transparencia para garantizar que los humanos estén informados cuando sea necesario. Al utilizar un chatbot, por ejemplo, los humanos deben ser conscientes de que están interactuando con una máquina para que puedan tomar una decisión informada sobre si desean seguir utilizando el sistema. Los proveedores también tendrán que garantizar que los contenidos generados por IA sean identificables.

Los sistemas de IA con un riesgo mínimo no tendrán restricciones y podrán utilizarse libremente. Esto incluye aplicaciones como videojuegos con IA o filtros de spam.

¿A quién afectará?

La Ley de la IA de la UE afectará principalmente a los proveedores, que se definen en sentido amplio para incluir a todas las personas jurídicas -ya sean autoridades públicas, instituciones, empresas u otros organismos- que desarrollen sistemas de IA o encarguen su desarrollo. Esta amplia definición garantiza que cualquier organización implicada en la comercialización de tecnología de IA en el mercado de la UE o en la puesta en servicio de dichos sistemas dentro de la Unión entre en el ámbito de aplicación de la Ley. Las responsabilidades de los proveedores en virtud de la Ley incluyen, entre otras:

- Cumplimiento de los derechos humanos: Garantizar que sus sistemas de IA no comprometen los derechos fundamentales de las personas, que incluyen la protección de la privacidad, la no discriminación y la salvaguarda de los datos personales.

- Gestión de riesgos: Llevar a cabo evaluaciones de riesgos exhaustivas para identificar y mitigar cualquier daño potencial que sus sistemas de IA puedan suponer para las personas o la sociedad.

- Medidas de transparencia: Proporcionar información clara y comprensible sobre el funcionamiento de sus sistemas de IA, la lógica que subyace a las decisiones de IA y las implicaciones de su uso.

- Normas de calidad y seguridad: Cumplimiento de normas de calidad y seguridad predefinidas que garanticen que los sistemas de IA son fiables, seguros y aptos para el fin previsto.

La Ley de IA de la UE también aborda las responsabilidades de los usuarios de los sistemas de IA, incluidas las personas jurídicas y físicas. Esto amplía el alcance de la ley a los particulares, no solo a las empresas u organizaciones.

En virtud de la Ley, los usuarios de sistemas de IA deben:

- Utiliza los sistemas de IA de forma responsable: Sigue las instrucciones y directrices del fabricante para el uso previsto y seguro de las tecnologías de IA.

- Supervisión y notificación: Supervisar el funcionamiento de los sistemas de IA en uso e informar de cualquier fallo o riesgo que encuentren a las autoridades o proveedores pertinentes.

- Gobernanza de datos: Asegurar que cualquier dato utilizado junto con los sistemas de IA se maneje de acuerdo con las estrictas leyes de protección de datos de la UE, como el GDPR, para proteger la privacidad y la información personal de los individuos.

¿Qué regulará la Ley de Inteligencia Artificial de la UE?

La Ley de Inteligencia Artificial es un texto legislativo histórico que abordará varias áreas clave relacionadas con la implantación y el funcionamiento de los sistemas de inteligencia artificial.

Ética y responsabilidad

Los sistemas de IA tienen el potencial de impactar en la sociedad, tanto positiva como negativamente de forma significativa. Las consideraciones éticas son primordiales, ya que las decisiones tomadas por los sistemas de IA pueden afectar a la vida, los medios de subsistencia y los derechos de las personas.

La Ley de Inteligencia Artificial pretende garantizar que la IA se desarrolle y utilice de forma ética, respete los derechos humanos y salvaguarde la seguridad de las personas. Subraya la necesidad de que los sistemas de IA se diseñen con un enfoque centrado en el ser humano, dando prioridad al bienestar humano y a las normas éticas.

Transparencia y responsabilidad

Uno de los retos de los sistemas de IA, en particular los basados en el aprendizaje automático y el aprendizaje profundo, es su naturaleza de "caja negra". Esta opacidad puede dificultar la comprensión de cómo se toman las decisiones, lo que suscita preocupación por la imparcialidad, la parcialidad y la discriminación.

La Ley de Inteligencia Artificial obliga a una mayor transparencia y documentación de los sistemas de inteligencia artificial, exigiendo explicaciones sobre su funcionamiento, la lógica que subyace a sus decisiones y los datos que utilizan. Esto es crucial para fomentar la rendición de cuentas y garantizar que los sistemas de IA no perpetúen o agraven las desigualdades sociales.

Competitividad

En la carrera mundial por el avance tecnológico, la UE aspira a situarse a la cabeza de la innovación ética en IA. Al establecer normas claras y armonizadas para la IA, la Ley de IA pretende crear un entorno estable y predecible que fomente la inversión y la investigación en tecnologías de IA.

Con esta claridad normativa se pretende impulsar la competitividad de las empresas europeas en la escena internacional, permitiéndoles innovar al tiempo que respetan elevadas normas éticas y de seguridad.

Confianza del usuario final

La aceptación pública y la confianza en las tecnologías de IA son esenciales para su adopción y éxito generalizados. La Ley de Inteligencia Artificial pretende reforzar la confianza pública en los sistemas de IA mediante la aplicación de sólidas salvaguardias, normas éticas y requisitos de transparencia.

Se espera que garantizar que las tecnologías de IA se utilicen de forma que protejan y beneficien a la sociedad aumente la confianza de los ciudadanos, lo que es crucial para integrar la IA en diversos aspectos de la vida cotidiana y la economía.

Normativa sobre IA en otras jurisdicciones

La UE no está sola en sus esfuerzos por regular la IA: Estados Unidos y el Reino Unido han avanzado mucho en la introducción de políticas nacionales.

En California, que es el hogar de líderes de la IA como OpenAI, Microsoft y Google, se presentó recientemente un proyecto de ley que pretende establecer "normas de seguridad claras, predecibles y de sentido común para los desarrolladores de los sistemas de IA más grandes y potentes", adoptando un enfoque que se centra estrechamente en las empresas que construyen los modelos a mayor escala y en la posibilidad de que puedan causar daños generalizados si no se controlan.

Mientras tanto, la Ley Local 144 de la ciudad de Nueva York, que se introdujo en 2021 y se aplica a los empleadores que utilizan AEDT para evaluar a los candidatos, exige que se realice una auditoría de sesgos en los procesos de contratación automatizados.

También se están tomando medidas a nivel federal. En octubre, el Presidente Biden promulgó una Orden Ejecutiva para establecer nuevas normas de seguridad y protección de la IA. La Orden ordena las siguientes acciones:

- Los desarrolladores de los sistemas de IA más potentes deben compartir los resultados de sus pruebas de seguridad y otra información crítica con el gobierno estadounidense.

- Desarrollar normas, herramientas y pruebas que ayuden a garantizar que los sistemas de IA sean seguros y fiables.

- Proteger contra los riesgos de utilizar la IA para diseñar materiales biológicos peligrosos.

- Proteger a los estadounidenses del fraude y el engaño posibilitados por la IA estableciendo normas y mejores prácticas para detectar contenidos oficiales generados por IA y autenticarlos.

- Establecer un programa avanzado de ciberseguridad para desarrollar herramientas de IA que permitan encontrar y corregir vulnerabilidades en software crítico.

- Ordenar la elaboración de un Memorándum de Seguridad Nacional que dirija nuevas acciones en materia de IA y seguridad.

Mientras tanto, los legisladores británicos también están planeando sus propias normas. En marzo de 2023, el Gobierno británico publicó su Libro Blanco sobre la IA, en el que expone sus propuestas para regular el uso de la IA en el Reino Unido. El Libro Blanco es una continuación del Documento de Política de Regulación de la IA, que introdujo la visión del Gobierno británico para el futuro de un régimen regulador de la IA "favorable a la innovación" y "específico para cada contexto" en el Reino Unido.

El Libro Blanco propone un enfoque de la regulación de la IA distinto al de la Ley de IA de la UE. En lugar de introducir nuevas normas generales para regular la IA en el Reino Unido, el Gobierno británico pretende establecer expectativas para el desarrollo de la IA junto con los reguladores existentes, como la Autoridad de Conducta Financiera, y facultarlos para regular el uso de la IA dentro de sus respectivas competencias.

Interrelaciones entre la Ley de AI y el GDPR de la UE

Cuando la Ley de IA de la UE entre en vigor, será una de las primeras y mayores normativas del mundo sobre IA. Naturalmente, esto ha llevado a la gente a pensar en sus implicaciones para el Reglamento General de Protección de Datos (GDPR), que entró en vigor en 2018.

La Ley de IA y el GDPR difieren en su ámbito de aplicación. La Ley de IA se aplica a proveedores, usuarios y participantes en toda la cadena de valor de la IA, mientras que el GDPR se aplica de forma más restringida a quienes tratan datos personales u ofrecen bienes o servicios, incluidos servicios digitales, a los interesados en la UE. Por tanto, los sistemas de IA que no procesen datos personales no entrarán en el ámbito de aplicación del GDPR.

Sin embargo, hay salvedades al respecto. Una posible laguna entre la Ley de IA y el GDPR es el requisito de que los proveedores de sistemas de IA faciliten la supervisión humana. Sin embargo, aún no se ha definido qué medidas deben tomarse para permitirlo ni en qué medida será necesaria la supervisión humana para sistemas de IA específicos. La implicación potencial es que los sistemas de IA no se considerarán parcialmente automatizados; por lo tanto, pueden aplicarse las obligaciones del artículo 22.

La Ley de IA también señala que los proveedores de sistemas de IA de alto riesgo podrían necesitar tratar categorías especiales de datos personales para la supervisión y detección de sesgos. Curiosamente, la Ley de IA no proporciona explícitamente una base jurídica para hacerlo, y las disposiciones del GDPR son una zona gris cuando se aplican en este contexto.

Podría existir un motivo legal de tratamiento para evitar datos sesgados y discriminación en virtud de la disposición sobre interés legítimo del artículo 6(1)(f), pero al tratar categorías especiales de datos también debe cumplirse una excepción del artículo 9(2). Esto significa que se necesita algo más que un interés legítimo. Aunque, en teoría, los operadores de sistemas podrían obtener el consentimiento explícito de los interesados para tratar los datos con el fin de eliminar sesgos, esto simplemente no es factible.

Estos son dos ejemplos de posibles puntos conflictivos que podrían entrar en juego entre la Ley de IA de la UE y el GDPR. Ambos marcos jurídicos son empresas complejas con diferentes alcances, definiciones y requisitos, lo que creará desafíos para el cumplimiento y la coherencia, que deben abordarse.

¿Cuándo entra en vigor la Ley de AI?

En principio, la Ley de IA debía entrar en vigor en 2022, pero, como siempre ocurre con las grandes empresas legislativas de este tipo, ha habido contratiempos.

La UE aprobó oficialmente la Ley de IA el13 de marzo de 2024, cuando los eurodiputados del Parlamento Europeo votaron a favor de su adopción, con una mayoría de 523 votos a favor y 461 votos en contra. Ahora se espera que el Consejo Europeo apruebe formalmente el texto final de la Ley de IA en abril de 2024. Tras este último paso formal y la conclusión de los trabajos lingüísticos sobre la Ley de AI, la ley se publicará en el Diario Oficial de la UE y entrará en vigor 20 días después de su publicación.

Una vez que la Ley de IA entre en vigor, las organizaciones dispondrán de entre seis y 36 meses para cumplir sus disposiciones, dependiendo del tipo de sistema de IA que desarrollen o implanten:

- 6 meses para los sistemas de IA prohibidos;

- 12 meses para las obligaciones específicas relativas a los sistemas de IA de uso general;

- 24 meses para la mayoría de los demás compromisos, incluidos los sistemas de alto riesgo del anexo III; y

- 36 meses para las obligaciones relacionadas con los sistemas de alto riesgo del anexo II.

A medida que esta legislación histórica avanza hacia su conversión en ley, las empresas deben comprender sus implicaciones y prepararse para los cambios que traerá consigo. Esta preparación implica varias acciones clave para garantizar el cumplimiento y aprovechar las oportunidades que puede ofrecer un entorno de IA bien regulado.

En primer lugar, las empresas deben revisar a fondo sus sistemas y aplicaciones de IA existentes. El objetivo de esta auditoría debe ser identificar las áreas en las que su tecnología podría no cumplir la próxima normativa. Dado que la Ley de IA se centra en los niveles de riesgo, es vital comprender en qué punto se encuentra cada sistema con respecto a su posible impacto en los derechos y la seguridad de las personas. Es posible que las empresas tengan que modificar o interrumpir ciertas funcionalidades de IA que entran en las categorías de mayor riesgo o en las consideradas inaceptables en virtud de la Ley.

Las empresas también deben centrarse en implantar procesos internos sólidos que garanticen la transparencia y la rendición de cuentas al utilizar la IA. Esto significa establecer prácticas de documentación transparentes, garantizar que los procesos de toma de decisiones sobre IA sean explicables y establecer mecanismos para supervisar e informar sobre el rendimiento y el impacto de la IA.