Equipe editorial da Getronics

Neste artigo:

A inteligência artificial (IA) passou de um conceito relativamente obscuro para algo que está mudando rapidamente nossas vidas em apenas alguns anos. De acordo com um estudo recente, o mercado global de IA crescerá 37% ao ano de 2023 a 2030, criando mais de 130 milhões de empregos. Embora essa rápida proliferação da IA traga entusiasmo e medo de forma proporcional, dependendo de quem você perguntar, existe um elefante branco na sala: a regulamentação.

As regulamentações de IA são inevitáveis com o avanço e a integração dos sistemas de IA em praticamente todas as facetas do mundo moderno. Jurisdições importantes, como a União Europeia, já estão avançando na introdução de estruturas legislativas projetadas para trazer a tão necessária ordem ao que tem sido citado como a versão tecnológica do Velho Oeste, e muitas outras virão à medida que a necessidade de supervisão em nível governamental aumentar.

A Lei de IA da UE

A Lei de IA da UE é um marco da legislação que visa criar uma estrutura jurídica abrangente que rege o uso e o desenvolvimento da IA em todos os Estados-Membros. Um componente vital da estratégia digital mais ampla da UE, a Lei de IA da UE reflete uma abordagem proativa para lidar com os desafios éticos, sociais e técnicos impostos pelo rápido avanço das tecnologias de IA.

A lei, aprovada pelos legisladores europeus em 13 de março de 2024, visa promover um ambiente em que as tecnologias de IA possam prosperar, impulsionando a inovação e o crescimento econômico e, ao mesmo tempo, garantindo que esses desenvolvimentos beneficiem todos os cidadãos e estejam alinhados com o interesse público. A lei também garantirá que os europeus possam confiar no que a IA oferece.

A Lei de IA da UE irá:

- Abordar os riscos criados especificamente pelos aplicativos de IA.

- Proibir práticas de IA que representem riscos inaceitáveis.

- Determine uma lista de aplicativos de alto risco.

- Definir requisitos claros para sistemas de IA para aplicativos de alto risco.

- Definir obrigações específicas para implementadores e provedores de aplicativos de IA de alto risco.

- Aplicar a fiscalização depois que um determinado sistema de IA for colocado no mercado.

- Estabelecer uma estrutura de governança nos níveis europeu e nacional.

- Exigir uma avaliação de conformidade antes que um sistema de IA seja colocado em produção.

Uma abordagem baseada em riscos para a governança de IA

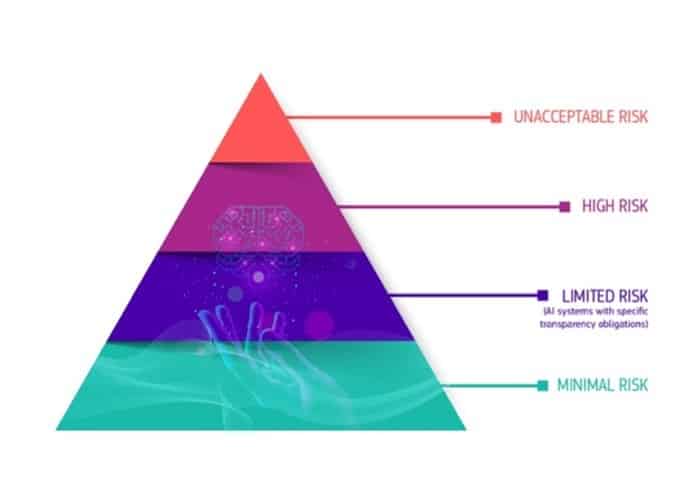

A estrutura regulatória estabelecida pela Lei de IA introduz o princípio de que quanto maior o risco apresentado por um sistema de IA, mais rigorosas serão as regulamentações a que ele está sujeito. Essa abordagem garante que os sistemas de IA com potencial para impactar significativamente a sociedade ou os indivíduos estejam sujeitos a supervisão e controle mais rigorosos.

Um dos principais aspectos da Lei de IA é a categorização de determinados aplicativos de IA como representando um risco inaceitável, proibindo efetivamente seu uso na União Europeia. Essa categoria inclui aplicativos de IA que:

- Manipulam o comportamento humano de tal forma que podem causar danos aos indivíduos. São sistemas projetados para influenciar ações ou decisões que podem prejudicar seu bem-estar ou autonomia.

- Facilitar a avaliação enviesada de indivíduos com base em seu comportamento social ou características pessoais. Um excelente exemplo é o sistema de crédito social implementado na China, que restringe as liberdades e oportunidades de uma pessoa com base em seu status social, conforme determinado por seu comportamento e outras características pessoais.

- Permitir a detecção remota em tempo real de pessoas em espaços públicos e sua identificação biométrica sem o consentimento delas. Embora essas práticas sejam amplamente proibidas devido à sua natureza intrusiva, a lei especifica exceções para prevenir o terrorismo ou investigar crimes graves, reconhecendo o equilíbrio entre as preocupações com a privacidade e as necessidades de segurança.

Os sistemas de IA identificados como de alto risco incluirão sistemas de IA usados em áreas importantes, como infraestrutura crítica (por exemplo, transporte), treinamento educacional ou vocacional (por exemplo, pontuação de exames), componentes de segurança de produtos (por exemplo, IA em cirurgia assistida por robô) e emprego (por exemplo, software de classificação de currículos). Os sistemas de IA de alto risco estarão sujeitos a critérios rigorosos antes de serem colocados no mercado:

- Sistemas adequados de avaliação e mitigação de riscos.

- Registro de atividades para garantir a rastreabilidade dos resultados.

- Informações claras e adequadas para o implantador.

- Medidas apropriadas de supervisão humana para minimizar o risco.

- Alto nível de robustez, segurança e precisão.

- A documentação detalhada fornece todas as informações sobre o sistema e sua finalidade para que as autoridades avaliem sua conformidade.

Enquanto isso, os sistemas de IA identificados como de risco limitado estarão sujeitos a obrigações específicas de transparência para garantir que os humanos sejam informados quando necessário. Ao usar um chatbot, por exemplo, os humanos devem ser informados de que estão interagindo com uma máquina para que possam tomar uma decisão informada sobre a continuidade do uso do sistema. Os provedores também terão que garantir que o conteúdo gerado por IA seja identificável.

Os sistemas de IA com risco mínimo não terão restrições e poderão ser usados livremente. Isso inclui aplicativos como videogames habilitados para IA ou filtros de spam.

Quem será afetado?

A Lei de IA da UE afetará principalmente os provedores, que são definidos de forma ampla para incluir todas as entidades jurídicas - sejam autoridades públicas, instituições, empresas ou outros órgãos - que desenvolvem sistemas de IA ou encomendam o desenvolvimento de sistemas de IA. Essa definição ampla garante que qualquer organização envolvida na colocação de tecnologia de IA no mercado da UE ou na colocação de tais sistemas em serviço na União se enquadre no escopo da lei. As responsabilidades dos provedores nos termos da lei incluem, entre outras, as seguintes

- Conformidade com os direitos humanos: Garantir que seus sistemas de IA não comprometam os direitos fundamentais dos indivíduos, que incluem proteções de privacidade, não discriminação e proteção de dados pessoais.

- Gerenciamento de riscos: Realizar avaliações de risco completas para identificar e mitigar qualquer dano potencial que seus sistemas de IA possam causar a indivíduos ou à sociedade.

- Medidas de transparência: Fornecer informações claras e compreensíveis sobre como seus sistemas de IA operam, a lógica por trás das decisões de IA e as implicações de seu uso.

- Padrões de qualidade e segurança: Aderir a padrões predefinidos de qualidade e segurança que garantam que os sistemas de IA sejam confiáveis, seguros e adequados à finalidade pretendida.

A Lei de IA da UE também aborda as responsabilidades dos usuários de sistemas de IA, incluindo entidades jurídicas e pessoas físicas. Isso estende o alcance da lei a pessoas físicas, não apenas a empresas ou organizações.

De acordo com a lei, espera-se que os usuários de sistemas de IA:

- Use os sistemas de IA com responsabilidade: Siga as instruções e diretrizes do fabricante para o uso deliberado e seguro das tecnologias de IA.

- Monitoramento e relatórios: Monitore o desempenho dos sistemas de IA em uso e informe quaisquer problemas de funcionamento ou riscos encontrados às autoridades ou provedores relevantes.

- Governança de dados: Certifique-se de que todos os dados usados em conjunto com os sistemas de IA sejam tratados de acordo com as rigorosas leis de proteção de dados da UE, como o GDPR, para proteger a privacidade e as informações pessoais dos indivíduos.

O que a Lei de IA da UE irá regulamentar?

A Lei de IA é um marco da legislação que abordará várias áreas importantes relacionadas à implementação e à operação de sistemas de IA.

Ética e responsabilidade

Os sistemas de IA têm o potencial de impactar a sociedade, tanto de forma positiva quanto negativa. As considerações éticas são fundamentais, pois as decisões tomadas pelos sistemas de IA podem afetar a vida, os meios de subsistência e os direitos das pessoas.

A Lei de IA tem como objetivo garantir que a IA seja desenvolvida e usada de forma ética, respeite os direitos humanos e proteja a segurança dos indivíduos. Ela enfatiza a necessidade de que os sistemas de IA sejam projetados com uma abordagem centrada no ser humano, priorizando o bem-estar e padrões éticos.

Transparência e responsabilidade

Um dos desafios dos sistemas de IA, especialmente aqueles baseados em aprendizado de máquina e aprendizado profundo, é sua natureza de "caixa preta". Essa opacidade pode dificultar a compreensão de como as decisões são tomadas, levando a preocupações sobre justiça, preconceito e discriminação.

A Lei de IA exige maior transparência e documentação para os sistemas de IA, exigindo explicações sobre como eles funcionam, a lógica por trás de suas decisões e os dados que utilizam. Isso é fundamental para desenvolver a responsabilidade e garantir que os sistemas de IA não perpetuem ou exacerbem as desigualdades sociais.

Competitividade

Na corrida global pelo avanço tecnológico, a UE pretende se posicionar como líder em inovação ética de IA. Ao estabelecer regras claras e harmonizadas para a IA, o AI Act busca criar um ambiente estável e previsível que incentive o investimento e a pesquisa em tecnologias de IA.

Essa clareza regulatória tem o objetivo de aumentar a competitividade das empresas europeias no cenário internacional, permitindo que elas inovem ao mesmo tempo em que aderem a altos padrões éticos e de segurança.

Confiança do usuário final

A aceitação e a confiança do público nas tecnologias de IA são essenciais para sua ampla adoção e sucesso. A Lei de IA tem como objetivo reforçar a confiança pública nos sistemas de IA, implementando respaldos robustos, padrões éticos e requisitos de transparência.

Espera-se que a garantia de que as tecnologias de IA sejam usadas de forma a proteger e beneficiar a sociedade aumente a confiança dos cidadãos, o que é crucial para a integração da IA em vários aspectos da vida cotidiana e da economia.

Regulamentações de IA em outras jurisdições

A UE não está sozinha em seus esforços para regulamentar a IA - os Estados Unidos e o Reino Unido fizeram progressos significativos na introdução de políticas locais.

Na Califórnia, sede de líderes em IA como OpenAI, Microsoft e Google, foi apresentado recentemente um projeto de lei que visa estabelecer "padrões de segurança claros, previsíveis e de bom senso para os desenvolvedores dos maiores e mais poderosos sistemas de IA", adotando uma abordagem que se concentra estritamente nas empresas que criam os modelos de maior escala e na possibilidade de que eles possam causar danos generalizados se não forem controlados.

Enquanto isso, a Lei Local 144 da cidade de Nova York, que foi introduzida em 2021 e se aplica a empregadores que usam AEDTs para avaliar candidatos, exige que seja realizada uma auditoria contra preconceitos e possíveis vieses nos processos de contratação automatizados.

As ações também estão ocorrendo em nível federal. Em outubro, o presidente Biden emitiu uma ordem executiva para estabelecer novos padrões de segurança e proteção de IA. A ordem orienta as seguintes ações:

- Os desenvolvedores dos sistemas de IA mais avançados devem compartilhar os resultados de seus testes de segurança e outras informações críticas com o governo dos EUA.

- Desenvolver padrões, ferramentas e testes para ajudar a garantir que os sistemas de IA sejam seguros, protegidos e confiáveis.

- Proteger contra os riscos do uso de IA para projetar materiais biológicos perigosos.

- Proteger os americanos contra fraudes e enganos habilitados por IA, estabelecendo padrões e práticas recomendadas para detectar conteúdo oficial gerado por IA e autenticado.

- Estabelecer um programa avançado de segurança cibernética para desenvolver ferramentas de IA para encontrar e corrigir vulnerabilidades em softwares críticos.

- Ordenar o desenvolvimento de um Memorando de Segurança Nacional que direcione ações adicionais sobre IA e segurança.

Enquanto isso, o legislativo do Reino Unido também planeja suas próprias regras. O governo do Reino Unido publicou seu Whitepaper sobre IA em março de 2023, que estabelece suas propostas para regulamentar o uso da IA no Reino Unido. O documento é uma continuação do AI Regulation Policy Paper, que apresentou a visão do governo britânico para o futuro de um regime regulatório de IA "pró-inovação" e "específico ao contexto" no Reino Unido.

O whitepaper propõe uma abordagem diferente para regulamentar a IA em relação à Lei de IA da UE. Em vez de introduzir regras novas e amplas para regulamentar a IA no Reino Unido, o governo britânico está procurando definir expectativas para o desenvolvimento da IA juntamente com os reguladores existentes, como a Autoridade de Conduta Financeira, e capacitá-los a regulamentar o uso da IA dentro de suas respectivas competências.

Interações entre a Lei de IA e o GDPR da UE

Quando a Lei de IA da UE entrar em vigor, ela estará entre as primeiras e maiores regulamentações do mundo sobre IA. Isso naturalmente fez com que as pessoas pensassem em suas implicações para o Regulamento Geral de Proteção de Dados (GDPR), que entrou em vigor em 2018.

A Lei de IA e a GDPR diferem em seu escopo de aplicação. A Lei de IA se aplica a provedores, usuários e participantes de toda a cadeia de valor de IA, enquanto o GDPR se aplica de forma mais restrita àqueles que processam dados pessoais ou oferecem bens ou serviços, incluindo serviços digitais, a titulares de dados na UE. Os sistemas de IA que não processam dados pessoais, portanto, não se enquadram no GDPR.

No entanto, há ressalvas quanto a isso. Uma possível lacuna entre a Lei de IA e o GDPR é a exigência de que os provedores de sistemas de IA facilitem a supervisão humana. Entretanto, ainda não foram definidas quais medidas devem ser tomadas para permitir isso e em que grau a supervisão humana será necessária para sistemas de IA específicos. A possível implicação é que os sistemas de IA não serão considerados parcialmente automatizados; portanto, as obrigações do Artigo 22 podem ser aplicadas.

A Lei de IA também observa que os provedores de sistemas de IA de alto risco podem precisar processar categorias especiais de dados pessoais para monitoramento e detecção de enviesamentos de dados. É interessante notar que a Lei de IA não fornece explicitamente uma base legal para fazer isso, e as disposições do GDPR não apresentam definições claras quando aplicadas nesse contexto.

Pode haver um fundamento de processamento legal para evitar dados tendenciosos e discriminação de acordo com a disposição de interesse legítimo do Artigo 6(1)(f), mas ao processar categorias especiais de dados, uma isenção do Artigo 9(2) também deve ser atendida. Isso significa que é necessário mais do que um interesse legítimo. Embora, em teoria, os operadores de sistema possam obter o consentimento explícito dos titulares de dados para processar suas informações a fim de eliminar preconceitos, isso simplesmente não é viável.

Esses são dois exemplos de possíveis pontos de atrito que podem surgir entre a Lei de IA da UE e o GDPR. Ambas as estruturas jurídicas são complexas e possuem diferentes escopos, definições e requisitos, o que criará desafios que precisam ser abordados de conformidade e consistência.

Quando a Lei de IA entra em vigor?

Inicialmente, a Lei de IA deveria entrar em vigor em 2022, mas, como sempre acontece com grandes projetos legislativos como esse, houve retrocessos.

A UE aprovou oficialmente a Lei de IA em13 de março de 2024, quando os deputados do Parlamento Europeu votaram pela adoção, com uma maioria de 523 votos a favor e 461 votos contra. Espera-se agora que o Conselho Europeu endosse formalmente o texto final da Lei de IA em abril de 2024. Após essa última etapa formal e a conclusão do trabalho linguístico sobre a Lei de IA, a lei será publicada no Jornal Oficial da UE e entrará em vigor após 20 dias.

Quando a Lei de IA entrar em vigor, as organizações terão entre seis e 36 meses para cumprir suas disposições, dependendo do tipo de sistema de IA que desenvolverem ou implementarem:

- 6 meses para sistemas de IA proibidos;

- 12 meses para obrigações específicas relacionadas a sistemas de IA de uso geral;

- 24 meses para a maioria dos outros compromissos, incluindo sistemas de alto risco no Anexo III; e

- 36 meses para obrigações relacionadas a sistemas de alto risco no Anexo II.

À medida que essa legislação histórica avança para se tornar lei, as empresas devem entender suas implicações e se preparar para as mudanças. Essa preparação envolve várias ações importantes para garantir a conformidade e aproveitar as oportunidades que um ambiente de IA bem regulamentado pode oferecer.

Em primeiro lugar, as empresas devem analisar minuciosamente seus sistemas e aplicativos de IA existentes. Essa auditoria deve ter como objetivo identificar quaisquer áreas em que sua tecnologia possa não estar em conformidade com as regulamentações futuras. Dado o foco da Lei de IA nos níveis de risco, é vital compreender a posição de cada sistema em relação ao seu possível impacto nos direitos e na segurança dos indivíduos. As empresas talvez precisem modificar ou descontinuar determinadas funcionalidades de IA que se enquadram nas categorias de maior risco ou naquelas consideradas inaceitáveis pela lei.

As empresas também devem se concentrar na implementação de processos internos robustos que garantam a transparência e a responsabilidade ao usar a IA. Isso significa estabelecer práticas de documentação transparentes, garantir que os processos de tomada de decisão sobre IA sejam explicáveis e estabelecer mecanismos para monitorar e relatar o desempenho e o impacto da IA.